文章编号:11493时间:2024-10-01人气:

HDFS 的默认数据块大小为 128MB,但在实践中,这个大小可能会根据具体应用场景进行调整。

一般来说,对于大多数应用场景,128MB 的默认数据块大小是一个合理的起点。但是,建议根据具体应用需求进行调整和测试,以找到最优值。

一,HDFS的基本特征与构架 1.基本特征 (1)大规模数据分布存储能力:以分布式存储能力和良好的可扩展性。

(基于大量分布节点上的本地文件系统,构建一个逻辑上具有巨大容量的分布式文件系统,并且整个文件系统的容量可随集群中节点的增加而线性扩展) (2)高并发访问能力:提供很高的数据访问宽带(高数据吞吐率),并且可以把带宽的大小等比例扩展到集群中的全部节点上 (3)强大的容错能力:(设计理念中硬件故障被视作常态)保证在经常有节点发生硬件故障的情况下正确检测硬件故障,并且能自动从故障中快速恢复,确保数据不丢失(采用多副本数据块形式存储) (4)顺序式文件访问:(大数据批处理都是大量简单数据记录的顺序处理)对顺序读进行了优化,支持大量数据的快速顺序读出,代价是对于随机的访问负载较高 (5)简单的一致性模型(一次写多次读):支持大量数据的一次写入,多次读取;不支持已写入数据的更新操作,但允许在文件尾部添加新的数据 (6)数据块存储模式:默认的块大小是64MB。

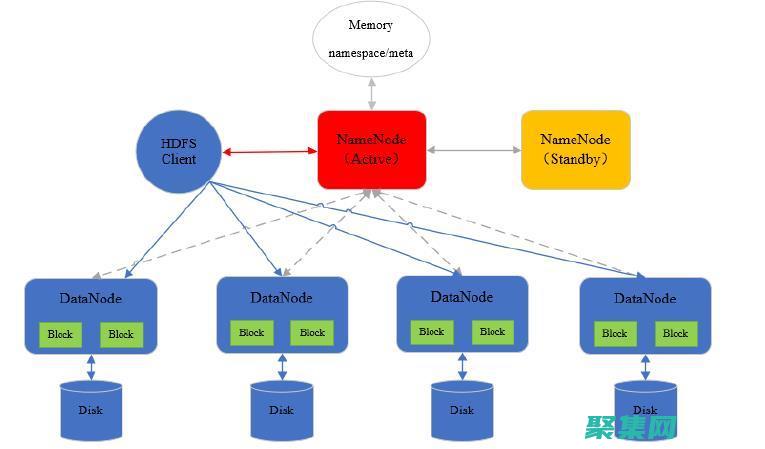

好处:减少元数据的数量,允许这些数据块通过随机方式选择节点,分布存储在不同地方 2.基本框架与工作过程 (1)基本组成结构与文件访问过程 [1]HDFS;一个建立在一组分布式服务器节点的本地文件系统之上的分布式文件系统(采用经典主-从结构) [2]主控节点nameNode: 1)是一个主服务器,用来管理整个文件系统的命名空间和元数据,以及处理来自外界的文件访问请求 2)保存了文件系统的三中元数据 命名空间:整个分布式文件系统的目录结构 数据块与文件名的映射表 每个数据块副本的位置信息,每一个数据块默认有3个副本 [3]从节点DataNode: 1)用来实际存储和管理文件的数据块 2)为了防止数据丢失,每个数据块默认有3个副本,且3个副本会分别复制在不同节点上,以避免一个节点失效造成一个数据块的彻底丢失 [4]程序访问文件时,实际文件数据流并不会通过NameNode传送,而是从NameNode获得所需访问数据块的存储位置信息后,直接去访问对应的DataNode获取数据 [5]设计好处: 1)可以允许一个文件的数据能同时在不同DataNode上并发访问,提高数据访问的速度 2)减少NameNode的负担,避免使NameNode成为数据访问瓶颈 [6]基本访问过程: 1)首先,用户的应用程序通过HDFS的客户端程序将文件名发送至NameNode 2)NameNode接收到文件名之后,在HDFS目录中检索文件名对应的数据块,再根据数据块信息找到保存数据块的DataNode地址,讲这些地址回送到客户端 3)客户端接收到这些DataNode地址之后,与这些DataNode并行的进行数据传输操作,同时将操作结果的相关日志提交到NameNode 2.数据块 (1)为了提高硬盘的效率,文件系统中最小的数据读写单元是数据块 (2)HDFS数据块的默认大小是64MB,实际部署中,可能会更多 (3)将数据块设置大的原因是减少寻址开销的时间 (4)当应用发起数据传输请求: [1]NameNode首先检索文件对应的数据块信息,找到数据块对应的DataNode [2]DataNode根据数据块信息在自身的存储中寻找相应的文件,进而与应用程序之间交换数据 [3]因为检索过程是但进行,所以要增加数据块大小,这样就可以减少寻址的频度和时间开销 3.命名空间 (1)文件命名遵循“目录/子目录/文件”格式 (2)通过命令行或者是API可以创建目录,并且将文件保存在目录中。

可以对文件进行创建,删除,重命名操作 (3)命令空间由NameNode管理。

所有对命名空间的改动都会被记录 (4)允许用户配置文件在HDFS上保存的副本数量,保存的副本数称作“副本因子” 4.通信协议 (1)采用TCP协议作为底层的支撑协议 (2)应用协议 [1]应用可以向NameNode主动发起TCP连接 [2]应用和NameNode交互协议称为Client协议 [3]NameNode和DataNode交互的协议称为DataNode协议 (3)用户和DataNode的交互是通过发起远程调用(RPC),并由NameNode响应来完成的。

另外,NameNode不会主动发起远程过程调用请求 5.客户端:是用户和HDFS通信最常见的渠道,部署的HDFS都会提供客户端 二,HDFS可靠性设计 数据块多副本存储设计 (1)采用了在系统中保存多个副本的方式保存数据,且同一个数据块的多个副本会存放在不同节点上 (2)优点: [1]采用多副本,可以让客户从不同数据块中读取数据,加快传输速度 [2]HDFS的DataNode之间通过网络传输数据,如果采用多个副本可以判断数据传输是否出错 [3]多副本可以保证某个DataNode失效的情况下,不会丢失数据 2.可靠性的设计实现 (1)安全模式: [1]HDFS启动时,NameNode进入安全模式 [2]处于安全模式的NameNode不能做任何文本操作,甚至内部的副本创建不允许 [3]NameNode需要和各个DataNode通信,获得其中保存的数据块信息,并对数据块信息进行检查 [4]只有通过了NameNode检查,一个数据块被认为安全。

当被认为安全的数据块所占比例达到某个阈值,NameNode退出 (2)SecondaryNmaeNode [1]使用它来备份NameNode元数据,以便在其失效时能从中恢复出其上的元数据 [2]它充当NameNode的一个副本,本身并不处理任何请求。

[3]作用:周期性保存NameNode的元数据 (3)心跳包和副本重新创建 [1]心跳包:位于HDFS核心的NameNode,通过周期性的活动检查DataNode的活动 [2]检测到DataNode失效,保存在其上的数据不可用。

则其上保存的副本需要重新创建这个副本,放到另外可用的地方 (4)数据一致性 [1]采用了数据校验和机制 [2]创建文件时,HDFS会为这个文件生成一个校验和,校验和文件和文件本身保存在同一空间上, [3]传输数据时会将数据与校验和一起传输,应用收到数据后可以进行校验 (5)租约 [1]防止同一个文件被多个人写入数据 [2]NameNode保证同一个文件只会发放一个允许的租约,可以有效防止出现多人写入的情况 (6)回滚 三,HDFS文件存储组织与读写 1.文件数据的存储组织 (1)NameNode目录结构 [1]借助本地文件系统来保存数据,保存文件夹位置由配置选项({}/{/tmp/dfs/name})决定 [2]在NameNode的${}之下有3个文件夹和1个文件: 1)current目录: 文件VERSION:保存了当前运行的HDFS版本信息 FsImages:是整个系统的空间镜像文件 Edit:EditLog编辑文件 Fstime:上一次检查点时间 2)目录:和上一个一致,但是保存的是上一次检查点的内容 3)image目录:旧版本的FsImage存储位置 4)in_:NameNode锁,只在NameNode有效(启动并且能和DataNode正常交互)时存在。

(2)DataNode目录结构 [1]借助本地文件系统来保存数据。

保存文件夹位置由配置选项{}决定 [2]在其之下有4个子目录和2个文件 1)current目录:已经成功写入的数据块,以及一些系统需要的文件 a)文件VERSION:保存了当前运行的HDFS版本信息 b)subdirXX:当同一目录下文件超过一定限制,新建一个目录,保存多出来的数据块和元数据 2)tmp目录和blockBeingWritten目录:正在写入的数据块,是HDFS系统内部副本创建时引发的写入操作对应的数据块 3)detach目录:用于DataNode升级 4)Storage目录:防止版本不同带来风险 5)in_文件:DataNode锁。

只有在DataNode有效时存在。

(3)CheckPointNode目录结构:和上一个基本一致 2.数据的读写过程 (1)数据读取过程 [1]首先,客户端调用FileSystem实例的open方法,获得这个文件对应的输入流,在HDFS中就是DFSInputStream [2]构造第一步的输入流时,通过RPC远程调用NameNode可以获得NameNode中此文件对应的数据块保存位置,包括这个文件副本的保存位置(注:在输入流中会按照网络拓扑结构,根据与客户端距离对DataNode进行简单排序) [3]-[4]获得此输入流后,客户端调用READ方法读取数据。

输入流选择最近的DFSInputStream会根据前面的排序结果,选择最近的DataNode建立连接并读取数据。

[5]如果已达到数据块末端,关闭这个DataNode的连接,然后重新查找下一个数据块 [6]客户端调用close,关闭输入流DFSInputStream (2)数据输入过程 [1]-[2]:客户端调用FileSystem实例的create方法,创建文件。

检查后,在NameNode添加文件信息,创建结束之后,HDFS会返回一个输出流DFSDataOutputStream给客户端 [3]调用输出流的write方法向HDFS中对应的文件写入数据。

数据首先会被分包,这些分包会写入一个输出流的内部队列Data队列中,接收完整数据分包,输出流回想NameNode申请保存文件和副本数据块的若干个DataNode [4]DFSDataOutputStream会(根据网络拓扑结构排序)将数据传输给距离上最短的DataNode,这个节点接收到数据包后传给下一个。

数据在各节点之间通过管道流通,减少传输开销 [5]数据节点位于不同机器上,数据需要通过网络发送。

(为保证数据节点数据正确,接收到数据的节点要向发送者发送确认包) [6]执行3-5知道数据全部写完,DFSDataInputStream继续等待知道所有数据写入完毕并确认,调用complete方法通知NameNode文件写入完成 [7]NameNode接收到complete消息之后,等待相应数量的副本写入完毕后,告知客户端 传输过程,当某个DataNode失效,HDFS执行: 1)关闭数据传输的管道 2)将等待ACK队列的数据放到Data队列头部 3)更新正常DataNode中所有数据块版本。

当失效的DataNode重启,之前的数据块会因为版本不对被清除 4)在传输管道中删除失效的DataNode,重新建立管道并发送数据包 文件系统操作命令 (1)HDFS启动与关闭 [1]启动过程: 1)进入到NameNode对应节点的Hadoop安装目录 2)执行启动脚本:bin/ [2]关闭过程:bin/ (2)文件操作命令格式与注意事项 [1]基本命令格式: 1)bin/hadoop dfs-cmd

HDFS适合存储大量的小文件是错误的。

HDFS的全称是Hadoop Distributed File System,即Hadoop分布式文件系统。 HDFS可将多台机器组合在一起进行数据存储,具有整体存储的能力。 HDFS推荐存储大文件,并不适合存储小文件,因为每个文件需要记录对应的元数据,这些元数据是存放在内存中的,当小文件足够多时,内存会更多的占用。

HDFS一般针对的是历史数据,故适合用来做离线计算和离线存储,由于历史数据一般比较庞大,处理起来比较耗时,所以,我们允许HDFS有一定的延迟,不用做到实时。 HDFS支持无限拓展,比如集群中的容量不够存储了,可以额外加机器,理论上是可以存储无限多的文件。

HDFS的特点

1、简单一致性模型

大部分的HDFS程序对文件操作需要的是一次写多次读取的操作模式。 一个文件一旦创建、写入、关闭之后就不需要修改了。 这个假定简单化了数据一致的问题,并使高吞吐量的数据访问变得可能,一个Map-Reduce程序或者网络爬虫程序都可以完美地适合这个模型。

2、流式数据访问

运行在HDFS之上的应用程序必须流式地访问它们的数据集,它不是运行在普通文件系统之上的普通程序。 HDFS被设计成适合批量处理的,而不是用户交互式的。 重点是在数据吞吐量,而不是数据访问的反应时间,POSIX的很多硬性需求对于HDFS应用都是非必须的,去掉POSIX一小部分关键语义可以获得更好的数据吞吐率。

HDFS(Hadoop Distributed File System)的默认副本保存数量取决于数据块的大小。 通常,数据块的大小设置为64MB或128MB,这意味着每个数据块在HDFS中都有三份副本,其中两份在不同的数据节点上,另一份在主副本所在的节点上。 这种设计是为了提高数据的可靠性和可用性。

此外,HDFS还支持通过配置来增加副本的数量,以应对不同的情况和需求。 例如,可以通过配置将更多的副本放在不同的数据节点上,以提高数据的容错性和可靠性。 同时,也可以通过配置将更多的副本放在相同的节点上,以提高数据的读取性能。 但是,由于HDFS是一个分布式文件系统,因此即使只有一个副本丢失,也不会影响整个文件系统的可用性。

但是,增加副本数量可以提高数据的可靠性和容错性,因此在一些关键应用中,通常会配置更多的副本。

注意:HDFS的副本数量是可以通过配置进行调整的,因此可以根据实际需求和环境来配置合适的副本数量。

hdfs不适合大规模数据批量离线计算。

Hadoop分布式文件系统(HDFS)是指被设计成适合运行在通用硬件(commodity hardware)上的分布式文件系统(Distributed File System)。 它和现有的分布式文件系统有很多共同点。 但同时,它和其他的分布式文件系统的区别也是很明显的。

HDFS是一个高度容错性的系统,适合部署在廉价的机器上。 HDFS能提供高吞吐量的数据访问,非常适合大规模数据集上的应用。 HDFS放宽了一部分POSIX约束,来实现流式读取文件系统数据的目的。 HDFS在最开始是作为ApacheNutch搜索引擎项目的基础架构而开发的。 HDFS是Apache HadoopCore项目的一部分。

数据特点

HDFS的设计是用于支持大文件的。 运行在HDFS上的程序也是用于处理大数据集的。 这些程序仅写一次数据,一次或多次读数据请求,并且这些读操作要求满足流式传输速度。 HDFS支持文件的一次写多次读操作。 HDFS中典型的块大小是64MB,一个HDFS文件可以被切分成多个64MB大小的块,如果需要,每一个块可以分布在不同的数据节点上。

一个客户端创建一个文件的请求并不会立即转发到名字节点。 实际上,一开始HDFS客户端将文件数据缓存在本地的临时文件中。 应用程序的写操作被透明地重定向到这个临时本地文件。 当本地文件堆积到一个HDFS块大小的时候,客户端才会通知名字节点。

大数据处理过程中所面临的挑战主要集中在数据复杂性、技术难题、安全与隐私问题以及人才需求四个方面。

数据复杂性是大数据处理的首要挑战。 大数据时代,数据量呈现爆炸式增长,数据来源和格式多样化,包括结构化数据、半结构化数据以及非结构化数据。 例如,社交媒体上的文本、图片和视频,或是工业设备产生的传感器数据等。 这些数据的整合、清洗和转换工作异常复杂,需要高效的数据处理技术和算法来应对。

技术难题也是大数据处理不可忽视的挑战。 随着数据量的激增,传统的数据存储和计算技术已难以满足需求。 分布式存储系统如Hadoop HDFS和计算框架如Spark虽然提供了解决方案,但在大规模数据实时处理、数据流转与计算资源的动态调配等方面仍存在技术瓶颈。 此外,数据质量的不稳定、数据噪声的干扰也增加了技术处理的难度。

安全与隐私问题在大数据处理过程中尤为突出。 大数据中蕴含大量个人和企业的敏感信息,如不加妥善保护,很容易遭受泄露和滥用。 因此,在大数据的采集、传输、存储和使用各个环节都需要实施严格的安全措施。 同时,符合法律法规的隐私保护技术,如数据脱敏、匿名化处理等,也是确保大数据安全合规使用的关键。

人才需求是大数据处理面临的另一大挑战。 大数据领域对专业人才的需求旺盛,这些人才需要具备深厚的数据分析技能、熟练的技术操作能力以及前瞻性的业务洞察力。 然而,当前市场上这类复合型人才供不应求,培养和引进足够数量和质量的大数据专业人才,是大数据处理领域持续发展的当务之急。

内容声明:

1、本站收录的内容来源于大数据收集,版权归原网站所有!

2、本站收录的内容若侵害到您的利益,请联系我们进行删除处理!

3、本站不接受违法信息,如您发现违法内容,请联系我们进行举报处理!

4、本文地址:http://www.jujiwang.com/article/55ac5d05a5ce5768123b.html,复制请保留版权链接!

语言cos的起源语言cos,也称为语言角色扮演,最早出现在20世纪90年代的日本弹幕游戏中,玩家们通过模仿游戏角色的说话、行为和动作来扮演他们喜爱的角色,随着互联网的普及,语言cos逐渐扩展到其他网络平台,例如论坛、聊天室和社交媒体,身体表现的意义在语言cos中,身体表现是表达角色性格和情绪的重要手段,通过不同的动作、手势和姿势,扮演...。

技术教程 2024-09-30 02:17:18

简介对于任何有抱负的Android开发者来说,搭建一个可靠且高效的开发环境至关重要,本文将指导您完成创建和配置Android开发环境所需的所有步骤,以优化您的工作流程和简化应用程序开发过程,设置先决条件在开始之前,您需要确保系统满足以下先决条件,Java开发套件,JDK,下载并安装最新版本的JDK,AndroidSDK,从Andro...。

技术教程 2024-09-28 17:21:41

新闻发布是一项艰巨且耗时的任务,涉及大量的手动劳动和协调,牛腩自动化新闻分发通过简化流程,减少人为错误,从而帮助企业提高新闻发布效率,下面是牛腩自动化新闻分发的优势和使用说明,牛腩自动化新闻分发优势提升效率,自动化分发新闻稿,释放企业时间专注于其他重要任务,减少人为错误,通过消除手动操作,减少错误的风险,提升准确性,确保新闻稿以一致的...。

最新资讯 2024-09-25 17:10:42

鼠标跟踪文字,激活阅读体验导言鼠标跟踪文字,MTF,是一种数字文本技术,允许读者在光标移动时突出显示文本,这种交互式功能增强了阅读体验,让文字仿佛具有生命,身临其境,本文将探讨MTF的功能和好处,并提供关闭它的方法,鼠标跟踪文字的功能MTF的主要功能是通过光标运动来突出显示文本,当读者将光标悬停在单词或句子上时,它会被高亮显示,使其比...。

技术教程 2024-09-24 18:47:33

ListBox控件是HTML中一个非常有用的元素,它允许用户从一组选项中进行选择,默认情况下,listbox控件的外观和行为可能并不总是满足特定的需求,通过使用CSS、HTML和JavaScript,可以对listbox控件进行广泛的定制,以创建具有独特外观和行为的自定义控件,自定义外观可以使用CSS轻松地自定义listbox控件的外...。

本站公告 2024-09-23 19:43:22

父母的孤儿进程的关键机制,有助于保持系统稳定性、防止资源泄漏并增强安全性,通过在,无父母的孤儿,设计模式中实现无孤儿清除,可以确保子进程在父进程退出时得到正确管理,从而创建一个更可靠且健壮的系统,...。

最新资讯 2024-09-13 23:07:02

多线程编程是提高应用程序并发性和性能的强大工具,在C语言中,多线程编程通过pthread库实现,高级技术互斥量互斥量用于确保共享资源在同一时间只能被一个线程访问,在pthread中,互斥量由pthread,mutex,t类型表示,可通过pthread,mutex,init函数初始化,对共享资源的访问应始终使用pthread,mutex...。

最新资讯 2024-09-12 15:11:10

在JavaScript中,函数是代码中的基本构建块,用于定义特定任务并进行重复使用,有两种主要的函数类型,普通函数和箭头函数,每种类型都有其自身的优点和缺点,普通函数普通函数是JavaScript中的传统函数类型,使用function关键字定义,普通函数具有以下语法,functionfunctionName,arg1,arg2,......。

最新资讯 2024-09-10 17:33:18

欢迎来到我们的源码教程,我们将指导您从编程初学者成长为技术精湛的大师,无论您是刚开始接触编程,还是想要提升您的技能,本教程都将为您提供全面的指导,第一章,初学者指南本指南将介绍编程的基础知识,包括,什么是编程不同类型的编程语言编写和编译代码的基础常见编程概念,如变量、函数和控制结构,学习资源CodecademyUdemyCourser...。

本站公告 2024-09-10 05:29:13

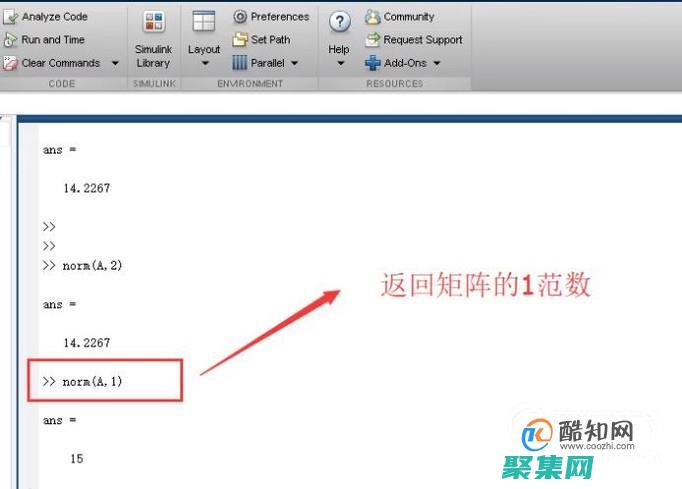

引言NORM函数是MicrosoftExcel中一个强大的工具,可用于执行各种数据规范化任务,通过理解其基本原理和高级应用,您可以大幅提升数据处理效率并获得更有意义的结果,基本原理NORM函数将给定值转换为正态分布中的标准分数,其公式为,=NORM.DIST,x,mean,standard,dev,cumulative,x,要标准化的...。

最新资讯 2024-09-09 19:15:50

欢迎来到学校网站构建指南,本指南将介绍学校网站构建过程中你需要了解的一切,从选择正确的平台到设计和开发你的网站,选择正确的平台在开始构建网站之前,你需要选择一个适合你的学校的平台,有许多不同的平台可供选择,每个平台都有其优点和缺点,以下是一些最受欢迎的学校网站平台,WordPress,WordPress是一个免费的开源平台,被广泛用于...。

最新资讯 2024-09-05 20:15:11

中国摩天大楼以其令人惊叹的高度和宏伟的建筑而闻名,但它们也成为超自然现象和幽灵传说的温床,其中最著名的摩天大楼之一是位于香港的中银大厦,一直是众多灵异事件的传闻之地,中银大厦中银大厦于1990年建成,高368米,是香港第五高的摩天大楼,由著名建筑师贝聿铭设计,以其独特的外形和三角形屋顶而闻名,中银大厦也因其与超自然现象的联系而声名鹊起...。

互联网资讯 2024-09-03 03:35:15