从零了解爬虫程序:跨越网络世界的桥梁 (爬虫从入门到实践)

从零了解爬虫程序:跨越网络世界的桥梁 (爬虫从入门到实践)

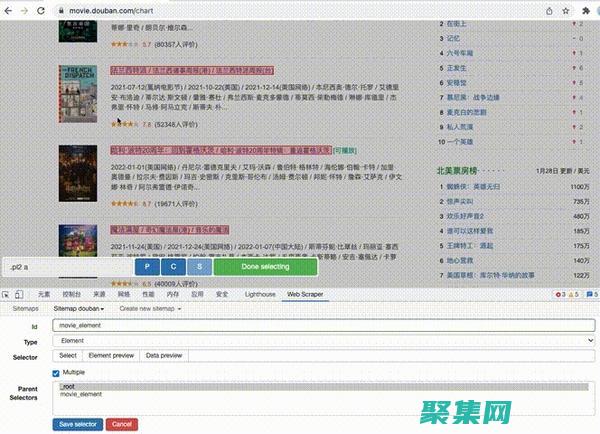

前言爬虫程序,也被称为网络爬虫或网络蜘蛛,是用于在互联网上自动提取信息的自动化工具,它们从一个URL开始,并根据预定义的规则爬行网站,抓取页面内容、图像等数据,爬虫程序的工作原理爬虫程序的工作原理遵循以下一般步骤,获取页面,爬虫程序使用HTTP请求向目标网站发送请求,获取目标页面的HTML内容,解析页面,它解析HTML内容以提取所需的...。

技术教程 2024-09-12 23:06:30