StringTokenizer 与其他字符串处理工具的比较:性能和功能分析 (stringbuffer与stringbuilder的区别)

StringTokenizer 与其他字符串处理工具的比较:性能和功能分析 (stringbuffer与stringbuilder的区别)

在Java中处理字符串时,有许多工具可用,包括StringTokenizer、StringBuilder和StringBuffer,每种工具都有其自身的优点和缺点,在选择最适合特定任务的工具时,了解它们的差异非常重要,StringTokenizerStringTokenizer是一个类,它允许您将字符串分解为一系列标记,它是一个轻量级...。

最新资讯 2024-09-27 16:24:31

StringTokenizer 替代方案:探索 Java 中其他字符串解析器选项 (string函数python用法)

StringTokenizer 替代方案:探索 Java 中其他字符串解析器选项 (string函数python用法)

StringTokenizer是一个Java类,用于将字符串分解成一系列标记,但是,它已经过时,现在有更好的选择可供使用,String.split,方法String.split,方法是StringTokenizer的最佳替代方法之一,它比StringTokenizer更简单、更易于使用,语法publicString[]split,...。

本站公告 2024-09-27 16:21:37

StringTokenizer 在实践中的应用:解决常见文本处理难题 (stringbuffer与stringbuilder的区别)

StringTokenizer 在实践中的应用:解决常见文本处理难题 (stringbuffer与stringbuilder的区别)

简介StringTokenizer是Java中一个实用的类,用于将字符串分解为一组更小的、有意义的标记,它提供了一种方便且有效的方法来处理文本数据,特别是在需要将字符串拆分成特定部分的情况下,StringBuffer和StringBuilder的区别在使用StringTokenizer时,了解StringBuffer和StringBu...。

本站公告 2024-09-27 16:17:05

StringTokenizer 用法详解:深入理解 Java 中的字符串分词 (string函数python用法)

StringTokenizer 用法详解:深入理解 Java 中的字符串分词 (string函数python用法)

简介StringTokenizer是Java中用于对字符串进行分词的高级类,它可以根据指定的分隔符将字符串拆分成一系列标记,token,与String.split,方法不同,StringTokenizer允许更灵活地控制分词过程,包括分隔符的选择、空标记的处理以及分词后的标记的访问方式,构造器StringTokenizer类提供了...。

互联网资讯 2024-09-27 16:13:38

揭开 StringTokenizer 的奥秘:Java 中强大的字符串解析器 (揭开st因子骗局)

揭开 StringTokenizer 的奥秘:Java 中强大的字符串解析器 (揭开st因子骗局)

在Java中,StringTokenizer是一个有用的类,它可以将字符串分解成一系列标记,tokens,它提供了一种简单的方法来处理字符串数据,并从复杂字符串中提取有用的信息,StringTokenizer的工作原理StringTokenizer根据指定的定界符,分隔符,将字符串分割成标记,定界符通常是单个字符,或者可以是一组字符...。

互联网资讯 2024-09-27 16:11:34

StringTokenizer 实践指南:通过示例学习 Java 中的字符串分块 (string函数python用法)

StringTokenizer 实践指南:通过示例学习 Java 中的字符串分块 (string函数python用法)

概述StringTokenizer是Java中一个强大的类,用于将字符串分块为较小的子字符串,标记,它是一个轻量级的工具,提供了高效的方式来处理字符串,使用StringTokenizer要使用StringTokenizer,您需要创建一个实例并向其中传递要分块的字符串,StringTokenizertokenizer=newStri...。

互联网资讯 2024-09-27 16:09:07

StringTokenizer 简明教程:掌握 Java 中的字符串解析技术 (string函数python用法)

StringTokenizer 简明教程:掌握 Java 中的字符串解析技术 (string函数python用法)

StringTokenizer是Java中用于解析字符串的实用类,它可以将一个字符串分割成一系列更小的字符串或令牌,StringTokenizer对于需要处理复杂字符串格式,例如CSV文件或URL,的应用程序非常有用,使用StringTokenizer要使用StringTokenizer,您需要先创建它的实例,然后调用nextToke...。

本站公告 2024-09-27 16:06:37

庖丁解牛字符串:使用 StringTokenizer 轻松分解文本数据 (庖丁解牛字符号是什么)

庖丁解牛字符串:使用 StringTokenizer 轻松分解文本数据 (庖丁解牛字符号是什么)

什么是庖丁解牛,庖丁解牛是一个成语,比喻做事精湛、熟练,在编程中,庖丁解牛字符串是指将字符串分解成更小的部分,以便于处理和分析,使用StringTokenizer分解字符串StringTokenizer是Java中的一个类,可以轻松地分解字符串,它通过将字符串分成一组标记,token,来工作,这些标记基于指定的定界符字符,要使用Str...。

互联网资讯 2024-09-27 16:02:57

Tokenize:自然语言处理领域的文本分词利器 (tokenizer)

Tokenize:自然语言处理领域的文本分词利器 (tokenizer)

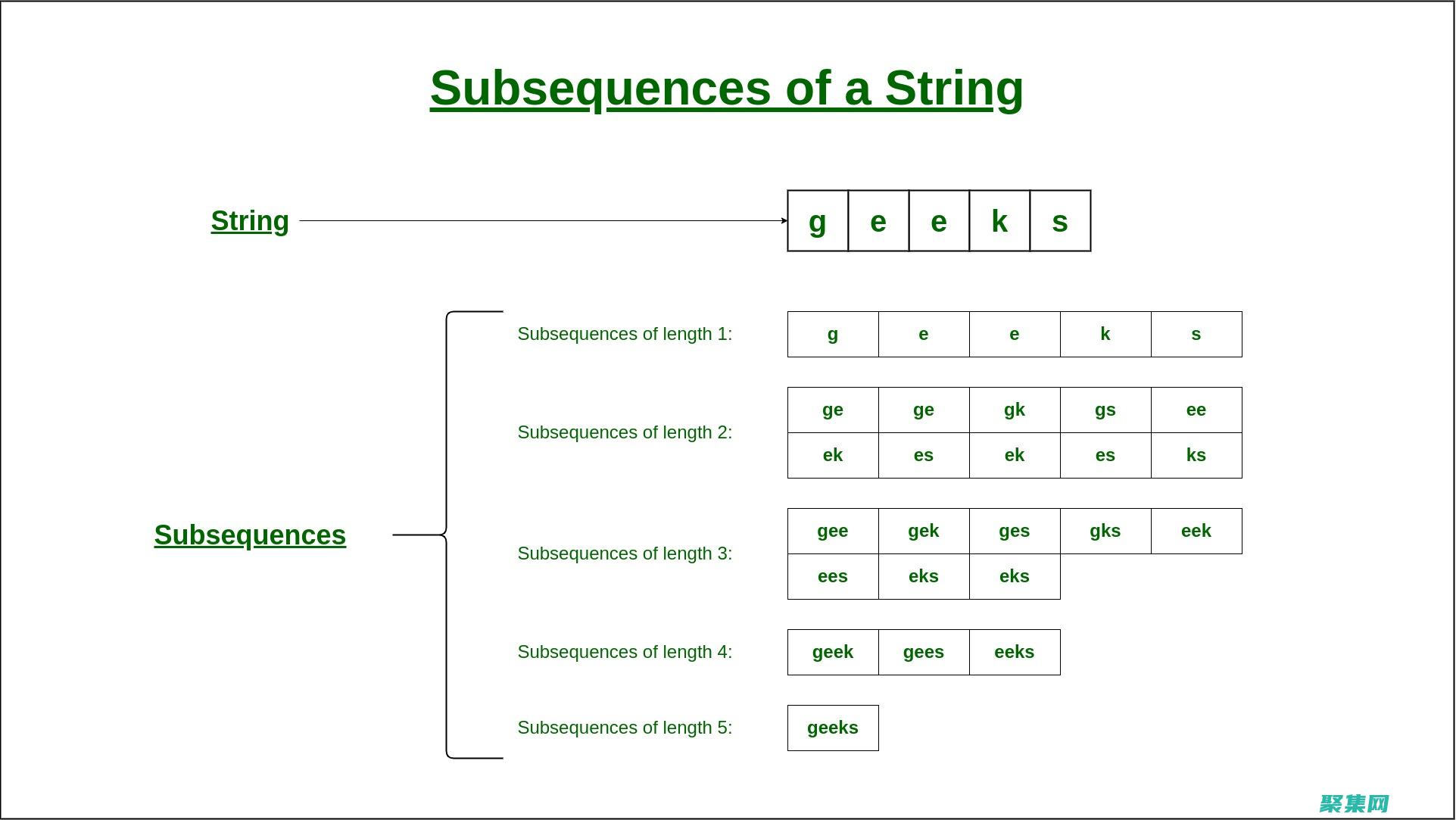

在自然语言处理,NLP,领域,分词是将文本分解为单个词或符号的基本过程,Tokenize是一种用于此目的的强大工具,它使NLP应用程序能够有效地处理文本数据,本文将深入探讨Tokenize,解释其功能、优点和应用,什么是Tokenize,Tokenize是一种算法,它将一段文本输入并输出一个词或符号列表,称为标记,这些标记代表文本中...。

本站公告 2024-09-23 23:18:36